Algoritmen in het AI tijdperk

Hoe om te gaan met softwareontwikkelingsrisico's volgens de EU AI Act?

In 2019 kwam eerder al een blog uit over Drie Codes Of Conduct in AI. Deze bekeek drie verschillende gedragscodes die er op dat moment waren over AI. We zijn intussen 4 jaar verder en sommige van deze richtlijnen gaat wetgeving worden, dus het is tijd voor een update.

Europese richtlijnen

In juni 2018 kwam de Europese Commissie met hun eerste versie van richtlijnen, waar ze in april 2019 een uiteindelijke versie van hebben gemaakt. Intussen ligt er een voorstel voor regels die nu bij het Europees Parlement liggen te wachten op goedkeurig. Dit heet de “EU AI Act” en zou de eerste uitgebreide AI-wet van de wereld zijn. In April 2021 is de eerste versie van deze wetten voorgesteld.

Deze wetten zouden gelden voor alle gebruikers en makers van AI-systemen in de EU, maar ook voor AI-systemen die buiten de EU gemaakt worden maar binnen de EU gebruikt worden. Er zijn een aantal uitzonderingen voor militaire systemen of rechtshandhaving.

Het doel van deze wetten is om er zeker van te zijn dat AI-systemen in de EU veilig, transparant, traceerbaar, niet-discriminerend en milieuvriendelijk zijn. Daarnaast moeten ze altijd gecontroleerd worden door mensen en komt er een duidelijke definitie van AI om te weten wanneer deze regels gelden. Dit zijn allemaal punten die ook terugkwamen in de blog uit 2019.

De definitieve definitie van een AI-systeem is op dit moment nog niet duidelijk, maar waarschijnlijk zal dit elk systeem zijn dat gebruik maakt van machine learning, op logica en kennis gebaseerde systemen, of statistische benaderingen.

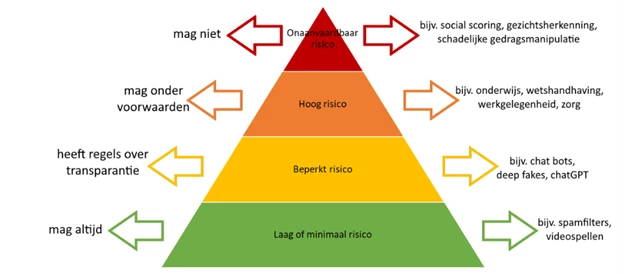

Een belangrijke toevoeging sinds de versie uit 2019 zijn de toegevoegde risiconiveaus. De nieuwste versie heeft namelijk verschillende regels afhankelijk van waar en waarvoor het algoritme gebruikt wordt. Hoe meer risico er aan een systeem zit, hoe strenger de regels waaraan deze zich moet houden.

Onaanvaardbaar risico

Je mag geen algoritmes maken met schadelijke cognitieve gedragsmanipulatie of algoritmes die misbruik maken van een specifieke minderheidsgroep. Ook mag een algoritme niet gebruikt worden voor ‘social scoring’, waar mensen een score krijgen afhankelijk van gedrag, status of persoonskenmerken. Daarnaast wordt ook real-time en remote biometrische identificatie verboden, hieronder valt ook gezichtsherkenning. Bij gezichtsherkenning zijn er een aantal uitzonderingen, dat mogelijk per lidstaat kan verschillen.

Hoog risico

Deze algoritmes mogen wel gebruikt worden, maar hier zijn veel voorwaarden aan. Onder hoog risico vallen twee categorieën:

- AI-systemen voor producten die al vallen onder EU-veiligheidswetgeving zoals speelgoed, auto’s, medische hulpmiddelen etc.

- AI-systemen in de volgende acht subcategorieën:

- Biometrische identificatie en categorisering van personen

- Beheer en exploitatie van kritieke infrastructuur

- Onderwijs en beroepsopleidingen

- Werkgelegenheid, werknemersbeheer en toegang tot zelfstandig ondernemerschap

- Toegang tot en gebruik van essentiële particuliere diensten en openbare diensten en uitkeringen

- Wetshandhaving

- Migratie-, asiel- en grenscontrolemanagement

- Hulp bij juridische interpretatie en toepassing van de wet

Alle systemen met hoog risico moeten in een EU-database komen voordat ze in gebruik genomen worden. Als er al veiligheidswetgeving is, moeten ze zich houden aan bestaande wetgeving. Als er nog geen wetgeving is, moeten deze systemen hun eigen systeem testen of ze zich houden aan de nieuwe eisen, waarna ze het CE-merk kunnen gebruiken. Enkel systemen die biometrische informatie gebruiken, moeten getest worden door een goedgekeurde instantie.

Deze systemen hebben ook verschillende regels over data, documentatie en traceerbaarheid, transparantie, menselijk toezicht, nauwkeurigheid en robuustheid.

Beperkt risico

Deze regels tellen voor systemen die interactie met mensen hebben (zoals chatbots), systemen met emotieherkenning, biometrische categoriseringssystemen en AI-systemen die foto’s, filmpjes of audio genereren of manipuleren, zoals deep fakes.

Voor deze systemen geldt een beperkt aantal regels over transparantie, zodat de gebruikers zelf afwegingen kunnen maken over het gebruik hiervan. Gebruikers moeten enkel geïnformeerd worden dat ze met een AI te maken hebben.

Generatieve AI-systemen als ChatGPT worden apart nog even genoemd. Deze systemen moeten ook duidelijk maken dat de inhoud door AI gegenereerd wordt, maar hiernaast wordt nog expliciet genoemd dat het systeem ontworpen moet worden zodat het geen illegale content genereert en er moet een samenvatting komen van welke trainingsdata auteursrechtelijk beschermd is.

Laag of minimaal risico

Alle systemen die niet vallen onder de bovenstaande categorieën, hebben geen regels. Wel wordt aangemoedigd om zich te houden aan de gedragscodes.

En nu?

Het Europees Parlement hoopt eind 2023 een eindversie te hebben van de AI Act, zodat deze in gebruik genomen kan worden. Ze raden op dit moment wel al aan om deze regelgeving in acht te nemen tijdens het maken van AI-systemen, omdat het uiteindelijk voor een groot deel wetgeving zal worden.

Links voor meer informatie

Wat is de EU AI Act?